从 @Mira_Network 的工作机制拆解如何辨别AI说的是真话!

现在的大多数用LLM模型的AI,经常一本正经的胡说八道,其实都没法做到可信。不是技术不行,是原理上就存在限制,无法同时要它准确又中立。

你训练的数据越多,越能减少偏见,但容易开始编故事。数据清洗得越干净,可能就更偏向某种立场。

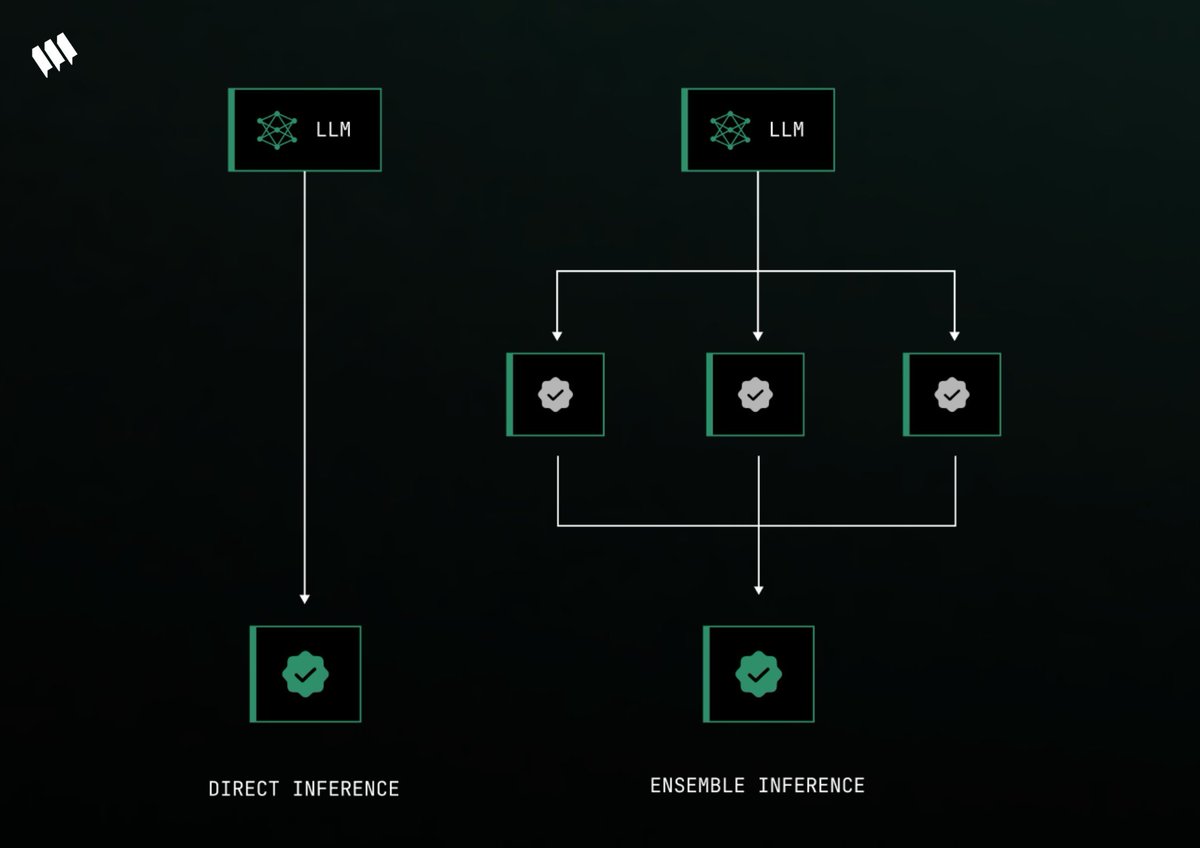

Mira 的核心机制是共识验证。其实就是不再依赖一个模型的回答,通过多个模型一起参与判断。只有当大家都说是,这条回答才算通过验证。

整个流程分为以下三步!

1⃣Binarization

AI 的回答不是一整段拿去判断,而是拆分成一句一句的小判断。

比如:地球绕着太阳转,月亮绕着地球转。

Mira 会把这句话拆成:

地球绕着太阳转

月亮绕着地球转

每一句话都会被独立验证。它避免了整体听起来好像对,其实细节全错的问题。

2⃣分布式验证

这些拆出来的语句会被送到 Mira 网络中的不同验证节点,每个节点都是一个模型或一组模型,它们不会看到完整的上下文,只负责判断自己那一条真假,保证验证更中立。

3⃣验证共识机制

Mira 的“工作量证明”是真实的 AI 推理。

每个验证模型都要 stake(质押)代币,验证完回答要给出结果。

如果表现不好会被“slash”,扣掉质押的代币。

模型的“共识计算”必须几乎所有模型都同意一条判断才算通过。这种机制,就是在用模型间的“多元共识”来逼近事实本身。

说到底, @Mira_Network 就是给AI 的输出加了一层可信度证明,这一层是通过共识达成的,而不是凭单个模型进行验证。

From X

Disclaimer: The above content reflects only the author's opinion and does not represent any stance of CoinNX, nor does it constitute any investment advice related to CoinNX.