今天上线了vibe coding的第二个产品:热点分析

让AI分析币圈热点,5分钟就可以掌握币圈的最热话题

这个功能现在很常见,那我花时间做的有何不同呢?

1 说人话的有趣AI

让AI写的报告有人味,文字的可读性更强。这是我精心调教的结果,经历了三次版本的迭代。第一版是在刚开始做AI分析的时候,我像大部分人一样,重心在功能的实现。

完工后我发现,AI写的报告平平无奇,并且带有很多晦涩难懂的专业名词。于是我进行改进,开始测试十几个不同的大模型,以及不同的Prompt工程。

因为我发现模型拥有不同的性格,有的输出文字细腻,有的严谨,有的喜欢自由发挥。在这个过程中,我自己也改变了想法,将原先追求专业深度的报告,转变为注重阅读体验的报告。

在我打算完工的时候,读着第二版的报告,总觉得内容不错但是表现力不够。于是,我开始调试temperature等参数,以及Prompt的微调,这是一次小心翼翼的尝试。需要允许AI有自己的个性,但是要防止它过于放飞。

因为AI的分析需要基于提供的数据,而不是它自己的知识库。同时允许它表达推文数据中的情感。比如当市场弥漫着恐惧情绪时,AI的文字就不能写得仿佛大家都很高兴。

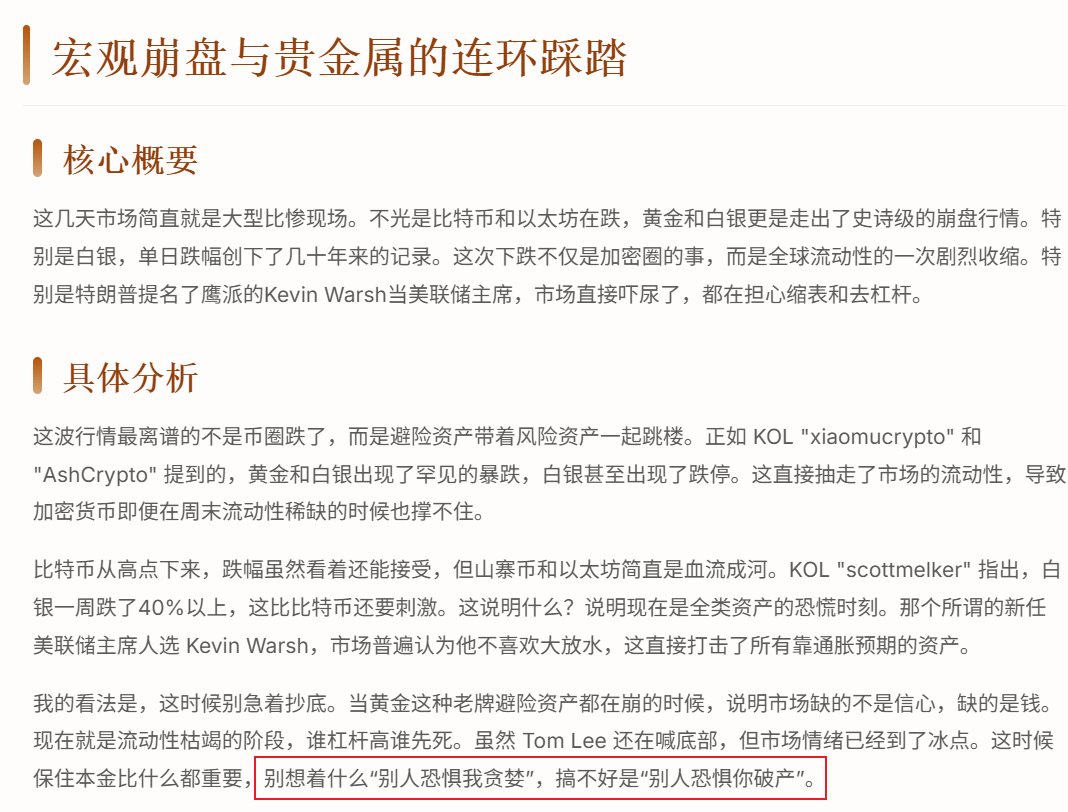

最终的效果还可以,AI具有人情味,比如它昨天的分析,最后会开玩笑的说:

别想着什么“别人恐惧我贪婪”,搞不好是“别人恐惧你破产”。

2 精心挑选的Top 1000 kol

我们都知道,数据的质量决定了结果。对于信息总结,KOL的选择也至关重要。这个时候KOL-Lens就发挥了它的价值。根据它的数据,我们挑选了币圈有影响力、战绩好、数据表现优异的KOL。

3 分析策略

当分析的推文数量达到几千条时,就无法一次性投喂给AI了。一方面涉及输入token超过最大限制;另一方面,由于几千条推文是非常凌乱的信息,AI对其信息的整合处理能力较弱。实测下来,准确度并不高。所以,我采用了一种新的分析方法。具体步骤如下:

第一步:数据清洗,去除无用的垃圾数据,提高AI的准确度

第二步:对每条推文进行实体命名分析,用于分类

第三步:对未命中实体的推文进行主题分类

第四步:分类报告分析

第五步:综合性去重

经过5步处理的方案,可以在大量数据的情况下,实现综合的分析。

网站:https://t.co/48vs0pf5xq

注册账户需要邀请码,请在此留言。(注,kol-lens的账号通用,不需要另外注册)

最近涌现了一类vibe coding增强的项目/工具,其中Superpowers,spec-kit、openSpec、BMAD最为有名,github上几个月就有万星。

我花了一些时间对他们进行了研究和测试。下面是我的建议

1 codex、claude code、open code等编程工具已经是非常强大了,记得第一步是先要善用他们,他们基本已经满足90%的需求场景。不要听信哪些自媒体的,为了凸显这些增强工具的好用,故意贬低他们。

2 如果是做一些自己用小工具,或者做一些修改。完全没有必要折腾这些。

3 如果你现在只是一些想法,并没有具体的细节。建议可以从superpowers开始,它会进行头脑风暴,并且一步步完善。

4 spec-kit和BMAD适合大型的比较复杂的项目。他们上来会书写比较复杂的文档规范。同时适合团队协作,项目的持久话运行和迭代。

5 OpenSpec是比较适合在已有的项目进行修改。但是如果是项目不大的小改动,用claude code这些就够了。但是很多人有个情况,是使用不同模型和ide。比如我写项目会让opus4.5写,修bug用codex。而且有时候antigravity抽风了,会用cursor。那么这时候他们的代码风格和写法可能差别比较大,这个时候,就要考虑使用openspec,或者找个skill。

1 Superpowers

Superpowers比较适合从0开始构建项目的场景。它是一个完整的软件开发工作流程,它更像是给现在 AI coding装上的“外挂大脑”和“多功能工具带”,或者更加通俗一点理解,就是组装了一个个专业的skills。

它可以安装在claude code、codex、open code。安装后,可以进行三个场景

1 第一步“头脑风暴

适合在项目的开始前的阶段,当你只有一个初步的想法,可以跟它进行讨论。它会问你一些问题,也是在满满将项目明确话

2 第二步:编写计划

根据上一步的设计方案。将工作分解成易于处理的小任务。而它的任务,比现在claude code,cursor等自己细分的任务往往更小,更细

3 第三步:执行计划

为每个任务派遣新的子代理,并进行两阶段审查(先检查规范符合性,再检查代码质量),或者分批执行,并设置人工检查点。

即使不适用superpowers,它github仓库里面的skills也值得来学习和借鉴。它里面有十几个精心设计的skills,覆盖一个开发的各个阶段。

2 spec-kit

spec-kit是github官方团队推出SDD(规范驱动开发),它是最具结构化、最像“工业级标准”的框架。它的特点,规范、详细。它适合比较复杂的项目、或者多人协作、或者需要长期维护的项目

而它的规范文档也是所有sdd中要求最高,数量最多的。简单来说,它认为在ai时代,由于代码将由ai来替代,所以最重要应该从ai代码的编写,转换为规范的定义。

spec-kit同样遵循,从定义规则,制定计划,执行计划并测试等过程。 spec-kit 区别于其他框架最大的亮点。它要求你在项目根目录维护一个 https://t.co/9m7C8CarC5(或者在 `.cursorrules` 中定义)。

--技术栈死规矩:比如“必须使用 Tailwind CSS,禁止使用 CSS Modules。”

-- *代码风格: “所有后端接口必须包含异常处理块,并返回标准的 JSON 格式。”

- 目录结构:“所有的业务逻辑必须写在 `services/` 目录下,Controller 层只负责转发。”

3 OpenSpec

openSpec 也是SSD,相对于spec-kit而言,它更轻量。它以“增量变更为核心,核心理念是:**既然项目是不断演进的,那么 AI 就不应该每次都去读几百行的完整文档,而应该只关注“这次改动了什么”。

除了更加轻量,它的另外一个有点极高的 Token 效率 (Token-Efficient):由于采用“增量(Delta)”模式,AI 只需要阅读和处理与本次改动相关的片段,而不是整个庞大的文档。这在处理大型老项目(Brownfield Projects)时能节省大量 API 开销,并减少 AI 的“幻觉”。

它更加适合边做边改的场景,并且**支持“倒推规范”:** 如果现在的项目还没有文档,OpenSpec 允许 AI 先阅读现有代码,反向生成(Reverse-engineer)出最初的规格文档。

4 BMAD

BMAD 是一套由 BMAD Code Org 推出的开源开发方法论。如果说 OpenSpec 和 spec-kit 是具体的“工具包”,那么 BMAD 更像是一本“现代 AI 软件工程教科书”。

实际上,BMAD跟上面的三个是不一样的,它更适合跟claude code等工程学的工具作为一类。他拥有12 位以上领域专家的agent,并且内部拥有34个工作流

它旨在解决一个核心矛盾:**如何在大规模、复杂的企业级项目中,让 AI 像一个成熟的开发团队一样工作,而不是像一个只会写代码片段的实习生。**

它的缺点也是太重,适合产生的代码极其稳健,适合金融、SaaS 等对安全性要求高的领域。并且不适合个人或者小型项目。

twitter刚刚开源了算法,我仔细了研究了一下,并且总结了一些获得阅读量和发帖的关键要点

第一部分 算法的核心

x推荐推文会分为三个步骤

第一步,从亿条推文中进行筛选

对于用户,会根据下面几个原则中

a 关注者:首先是从你关注的人中的推文

b 协同过滤(Collaborative Filtering):比如跟你有类似行为的用户点赞,简单来说,就是跟你臭味相投的人的中推荐

c 二度人脉的人:就是跟你二度人脉的人关注或者喜欢的帖子

d 语义向量搜索:** 算法将“用户”和“帖子”都转化为高维空间中的向量。如果你的兴趣向量和某条帖子的内容向量在空间上非常接近,它就会被选中。

这一步会筛选出1000~5000条推文,这里可以看出,推特根据兴趣,以及相似行为的进行推荐。而关注者的推文只占其中的4分之一。这也就解释了为何很多十几万的大V,有时候推文的阅读量并不高。

*第二步:排序阶段(Ranking)

在这一步,系统会 Phoenix这样的大型深度学习模型,对每一条帖子进行精密打分,。而指标是多维度的,基本上涵盖了我们所见的内容了,一共有15个正向:

1. **Favorite** (点赞)

2. **Reply** (回复)

3. **Retweet** (转推)

4. **Quote** (引用/转发并评论)

5. **Photo Expand** (点击查看大图)

6. **Click** (点击链接/卡片)

7. **Profile Click** (点击头像进主页)

8. **VQV** (Video Quality View - 有效视频播放)

9. **Share** (分享)

10. **Share via DM** (通过私信分享)

11. **Share via Copy Link** (复制链接分享)

12. **Dwell** (停留/驻足,指在这个推文上停下来)

13. **Dwell Time** (停留时长,这是连续变量,停得越久分越高)

14. **Quoted Click** (点击了引用推文中的原推文)

15. **Follow Author** (看完推文后关注了作者)

但是,github上面并没有公布权重。所以我们没办法猜测哪些维度更加重要。或者说,推特可能动态的调整这些维度的权重。

第三步:过滤与重排

这是对上一步排列的帖子做最后的过滤。一般都是合规类的,安全合规:自动剔除仇恨言论、色情、暴力或已删除的内容。去重:过滤掉你已经看过,或者内容高度重复的推文。

需要注意的是:如果排名靠前的都是同一个作者,算法会强制压低后续相同作者的分数,让你看到更丰富的内容。

第二部分:几个要点总结

1 出爆款要跨过一个门槛。

在代码中,直接写明了Prioritize in-network candidates over out-of-network candidates。也就是在推荐系统中,路人的系数是要打一个折扣的,虽然这个折扣的系数并没有公布。但是代码中明确指出,推荐给路人要比粉丝要难。那么这就意味着,要让路人看到,就需要积累一定的数据

2 Blue Check(蓝标认证)权重加成。

在 IneligibleSubscriptionFilter 中,系统会检查订阅状态。虽然具体的加权数值(Weight)隐藏在 params 里,但将“是否订阅”作为一个独立特征(Feature)输入给模型,本身就说明了它对打分有直接影响。

而且马斯克公开表示过,为了对抗 Bot,未认证用户的推文在“For You”中的可见性会被通过算法大幅压制。

3 发文频率有时候很重要

发推频率是一个比较容易踩坑的地方。代码里有一个叫 `AuthorDiversityScorer`(作者多样性打分器)的家伙。 它的逻辑非常“铁面无私”:如果你在短时间内连发好几条,系统就会认为你在刷屏,第 2 条以后的分数会直接被**乘上一个衰减系数**。

也就是说,如果你发帖太过频繁,而且是坏事

4 在你粉丝活跃的时间发帖

这条不是玄学,而是可以确定的事实了。虽然不在直接的算法代码中。但是可以从逻辑中推理出这条重要的规则。具体来说。

twitter推荐的算法中,包含了评论、点赞等一系列的指标。如果发文章的时候,粉丝都在睡觉,那么这些数据就很小。而当粉丝刷推特的时候,这篇文章将跟其他的数据来的一起排序,那么最后肯定被排在很后面。

5 把握“黄金一小时”:启动速度决定上限

算法会先将你的帖子推送给一小部分活跃粉丝,观察他们的 **Engagement Velocity(互动速率)**。并且结合第四点,所以建议把握黄金一小时 在你的**粉丝最活跃的时间点**发布内容。如果前 30-60 分钟互动数据惨淡,算法会判定该帖质量一般,停止向 Out-of-Network 扩散。

可以考虑发布后,立即在其他社交频道(如 Telegram/Discord)引导核心粉丝来互动,人为制造一个初始的脉冲信号。

6 重视:回复、评论、用户停留时间

虽然代码中没有公布各个指标的权重。但是埃隆·马斯克(Elon Musk)的公开解释:他在 X 上多次公开解释过这套算法的逻辑,明确说过“回复的权重是非常高的”。并且按照推荐系统的通用工业标准,稀疏行为(如回复)的权重必然远大于稠密行为(如点赞),否则模型无法收敛。

优质KOL推荐第一波:

通过KOl Lens数据,寻找能挖掘早期Alpha暴富的人

在大量数据的第一轮挑选后,还经过我人工审核,广告营销、撸嘴的、推荐太多币、MeMe信号等一律去除。

只保留真人,有真内容,并且推荐过多个高倍数项目。的kol

@YuGuan1209

鱼人#鱼馆代表作:Aster开盘就喊买入,COAI, STBL几乎是最早推荐的。

@CryptoLady_M

LADY M是英文区的kol,主要讨论项目居多,MEME占比少。并且谈的很多项目跟中文区差异很大。可以扩宽视野。这最近6个月来,推荐的TROLL、RAGE、AVNT都有10倍以上。

@xincctnnq

币圈女菩萨发文频率不高,但是战绩非常优秀的。其中xdog、TOTAKEKE在推荐后最高有20倍的涨幅

@Eveningtraders

这是一个经常用nansen数据做分析的英文区账号。很多分析的非常的准确。对PIPPIN MYX GIGGLE的推荐时间都把握的非常好,推荐有最高有10多倍的涨幅。

@gongyue777

这个一个喜欢链上MEMe的kol,推荐的MeMe经常有二段的机会。

@kaylyn_0x

凯林拥有独到的见解,并且紧跟时时热点。钟情于virtual生态。PRXVT FACY FREDI都有非常不错的涨幅

@Cryptoaeon

Aeon是英文区研究早起ALpha的项目,发文频率不高,推荐的项目也相对比较少。但是成绩很优秀,比如Nock有12倍的涨幅,AVICI TRWA GAI都有5~8倍的涨幅。

@Rafi_0x

Rafi_0x 是英文期喜欢研究早起alpha项目的kol,(似乎纯链上MeMe的不多)。推荐的项目质地不多。XVM ASTER AVICI HYDX 都有5~13倍的涨幅。

号外号外,今天上线了今年的第一个vibe coding项目:KOL Lens。

1 我为什么要做?

推特是币圈最重要的信息来源。所以,今年我的计划是找到一批优质的KOL列表,再结合AI进行深度分析。

这些目标主要包括:

1)擅长分析BTC走势的KOL

2)擅长挖掘早期Alpha的KOL

3)擅长链上数据分析的KOL

但我遇到了一个最大的问题:如何来评判KOL的“擅长”?

现在的KOL多如牛毛,而我要识别其中真正优质的账号。我研究了Kaito、Xhunt、Cookie等工具,发现都无法完全满足我的需求。如果人工查看,不仅费时费力,准确度也难以保证。

于是,数据分析出身的我,加上vibe coding的加持,决定亲手做这个KOL的综合数据分析工具。

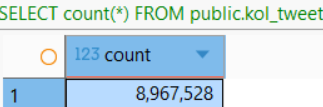

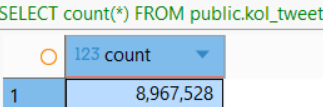

这次我一共分析了3万多个KOL,基于将近900万条推文。好在我前段时间花大力气微调了一个专门分析币圈的模型,否则如果直接使用Gemini-3的API分析,光是做一轮实体命名识别,成本就要将近10万刀。

下面是各个数据维度的介绍:

2 推特的基本情况

挑选KOL,第一眼可以看的数据,是平均每日发推文的数量。

如果数量太高,比如每日超过8条,那么有很大的概率是AI写作在不停地发文。即使是人在写,如此高频的内容,有效信息的占比往往也不大。反之,如果数字太小,说明不怎么活跃,也没有关注的必要。

其次是推文字数分布。如果长篇和超长篇占比多,说明博主喜欢输出深度内容。而在截图中,短篇占比很大,文字较少。

再结合浏览量分布来看,截图中的账号推文浏览量基本在1K~5K之间。

所以,这个KOL的基本画像已经勾勒出来了:这是一个每天发很多推文(5条以上),但内容都很短,且浏览量不高的账号。如果是我,第一时间就会Pass了。

另外,通过各时段的发推时间,可以看到它的活跃规律。比如截图显示在0时区(UTC)的早上7点数量最多,大概率是定时发布的。而发推数量非常低的时段,应该是睡觉时间。

可以看出,这个账号并不在美国,睡觉时间大概是北京时间的早上7点左右。

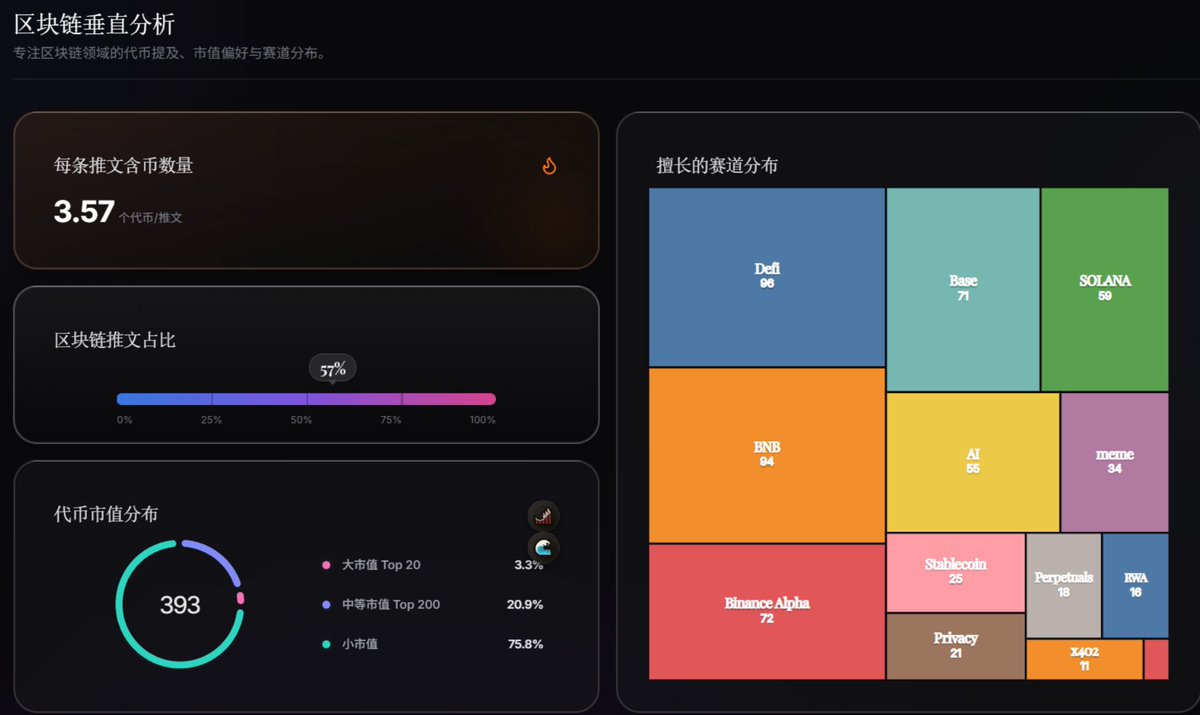

3 区块链方面的分析

首先,我设置了两个指标,来分析KOL推文中“含币量”的成分:

推文平均字数:在上图中可以看到,涉及区块链的文字字数(444)远大于非区块链内容(142),说明这个KOL在写币圈内容时,篇幅更长,更用心。

区块链推文占比:截图显示为57%。这意味着,57%的推文是写区块链的。这个数据太低,在我这里是一票否决的。如果它小于10%,这意味着90%的推文都不是讲区块链的,那我觉得这个人的主要精力不在币圈。

其次,从图中还可以挖掘出更重要的信息:

讨论过的币的数量:截图中有393个。很明显太多了,这是一个喊单非常多项目的KOL。即使某些币涨幅很高,跟着他赚钱的概率也不大。

代币的市值分布:这可以很容易看出这个KOL的偏好成色。是喜欢大市值的,还是小市值的?在寻找不同类型的KOL时,这是极其重要的指标。如果是找BTC趋势大牛,那么一定要大市值占比高;如果是找早期Alpha的KOL,那么小市值的占比要非常高。

擅长的赛道分布:一眼就能看出这个KOL聊的项目的领域。比如图中的x402赛道都有11个项目,说明它是紧跟热点的。

从截图中可以看到,这个KOL追求早期Alpha,紧跟热点。但问题是分析的项目数量太多,并不是最理想的人选,只能放在待定列表吧。

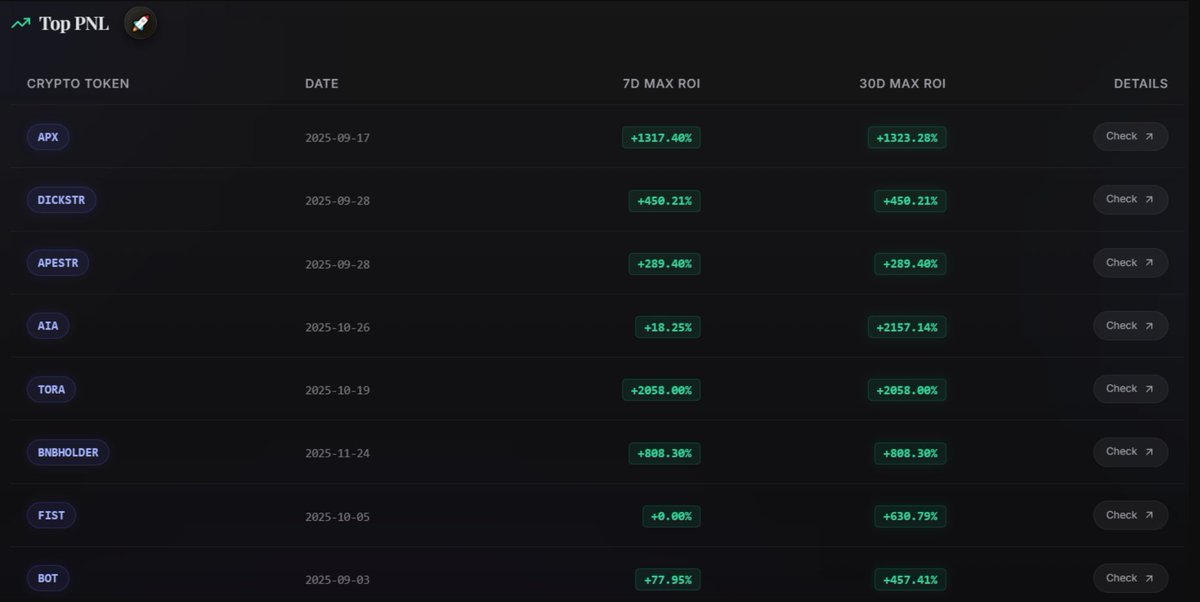

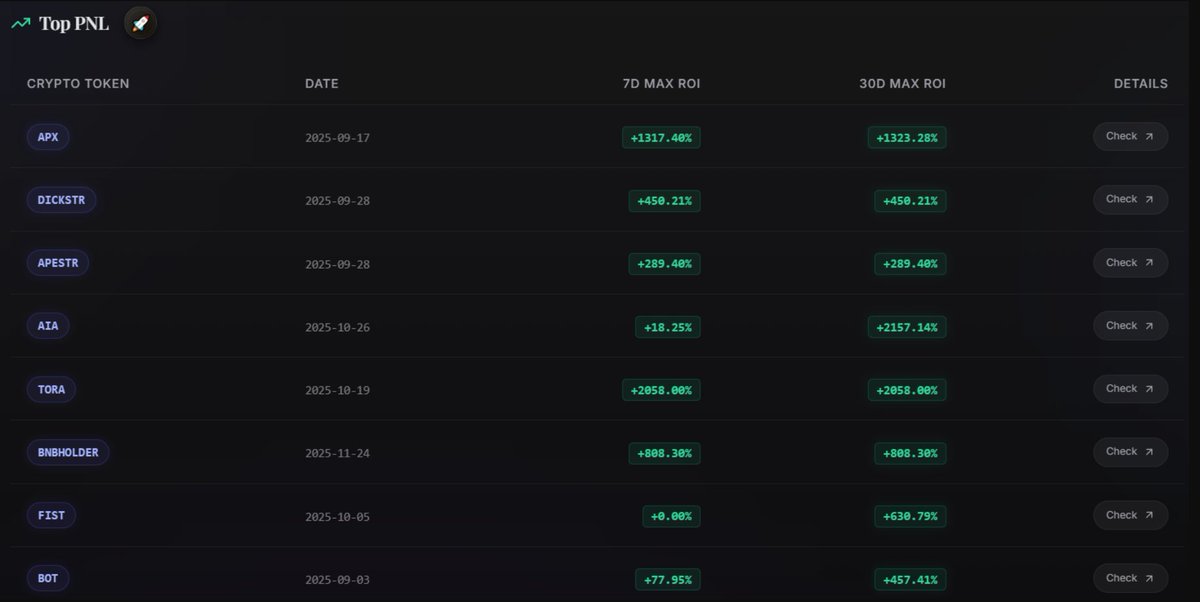

4 PNL(盈亏分析)

KOL的战绩,是最直观体现其水平的指标。

看截图中的KOL,在过去的3个月,能有2个20倍的币,一个10多倍的币,战绩确实不错。我已经将其放入精选KOL列表了,哈哈哈哈

除了看直接的数据,还有一些角度也能看出门道:

上榜的代币:如果都是小市值的,说明这个KOL比较擅长抓早期Alpha项目。

7天最大ROI vs 30天最大ROI:如果两个数值一样,说明这个KOL推荐后的7天内收益达到最大,适合短平快操作。如果7天最大ROI较小,到了30天突然变大,说明这个KOL推荐的项目适合长期埋伏。

当然,PNL还能挖掘更多信息,我打算后面继续完善。

5 网站信息

目前 https://t.co/7dHl1TjRtt 已经可以访问。在网站的搜索栏里可以查看各类KOL的数据。

考虑到早期的网站功能可能还不完整,所以先进行限额测试,需要邀请码才能注册并使用。

需要邀请码的朋友,可以在这里留言。

说几个最近的体会

1 写代码能力,codex 中 gpt 5.2-codex-high是最强的。适合写比较复杂的产品或者找难找的bug。好几个别人解决不了的bug,它能解决。缺点是它非常的慢,不要用来做小改动。改一个小地方能看一个礼拜的凡人修仙传了。

2 写代码能力,其次是claude opus 4.5. 质量和能力仅次于第一名。但是速度要快很多。而且在antigravity中就可以使用。

3 gemini 3 pro。前端是最强的,我的前端的时候都交给它,并且审美基本在线。除了coding,其它的场景也非常推荐它。日常对话,并且连接google生态。google是大善人,量大管饱,申请一个美国的教育资格可以免费用1年。

4 claude sonnet 4.5 就很尴尬了。我已经一段时间没用了。能力没有前面3个强。如果用api,价格还很贵。如果是包月,更推荐使用opus 4.5。

5 实惠之选glm4.7。代码能力还行,而且它们家的模型更新速度快。重要的是价格实惠,一个月20人民币不到。基本用不完。可以用来做些小的改动等等。

6 不要太相信什么ai的排行榜,也不要太相信那些自媒体。出一个新的就吹世界第一。不知道是拿了黑心钱,还是真的不懂。浪费别人的时间和精力。

我发现对AI 编程的评测很多,而对AI文本总结和写作方面的评测却非常少。

正好我最近有这方面的工作需求,对比分析几个主要AI的文字能力。就做一些总结。

对于实际使用的话,我就分为两大类。

第一类是gemini 3 pro, sonnet 4.5 和 gpt 5.1为阵营的大模型。

它们比其他的大模型表现更加出色,而这三个中最优的是gemini 3 pro。它写的报告,阅读体验最好,读起来流畅自然,极具感染力。

但是,这三个共同的特点,就是贵。主要两种场景可以

1)频次不高的写作

2)在网页或者客户端使用

但是,特别不适用api调用。

第二类:国产的几个大模型。

在很多场景下面,需要使用api来进行大量的文本总结分析, 比如收集大量文章让AI出总结报告,写长篇小说,或者批量写文章。这种情况用第一类的模型,显然成本太大。这时候国产的几个大模型就是最好的选择了:成本可以节省很多,同时效果也还可以。

Kimi k2 Thinking

Kimi k2在文字写作上面是国内模型中表现最佳的。**它是优秀的新闻记者。文笔流畅度仅次于 Gemini 3,擅长平衡报道。API的成本也是国产模型内最贵的,但是依然比国外大模型便宜很多。

DeepSeek V3.2

deepseek v3.2是刚发布的正式板。它逻辑清晰,信息量大,读起来不如Gemini轻松,但是也还可以。它对大量文本的内容挖掘是最深的。

它现在是我选择使用的模型,在大量文本进行总结分析的情况下,它表现很好,api也便宜

Qwen3-235b-a22b-thinking

阿里的Qwen3,它的文章特别专业,缺点是特别的长,而且阅读起来很难度。而且,它作为开源的模型,分析的时间是最长的,是别人的3倍以上。

Minimax M2

Minimax M2是一个中规中矩的模型,优点不突出,缺点也不明显。阅读提议良好,专业度良好,别人的缺点它也有,但是程度比较轻。让我感受不到用它的理由。

GLM 4.6

GLM 4.6这个模型,看的出来,它在很努力的满足我的prompt。但是总归还是差一点。比如说,我让prompt中要求结合提供的材料的基础上面进行分析,而它会大量引用材料,然后硬给一个总结。可能如GLM 4.6 官方介绍的一样,它是为了code 和agent而生的模型。

Doubao 251015

doubao 是表现最差的一个模型。它是丢失了所有细节、语境和情绪,分析深度最弱。

我也是非常的奇怪,doubao 1.6刚出来了,我是测试过这个性能的,当时表现是相当不错。它中间还升了一次级。为何表现会越来越差。看来大模型的降智不仅仅是claude,其他的大模型都有可能发生。

注:以上都使用thinking模式

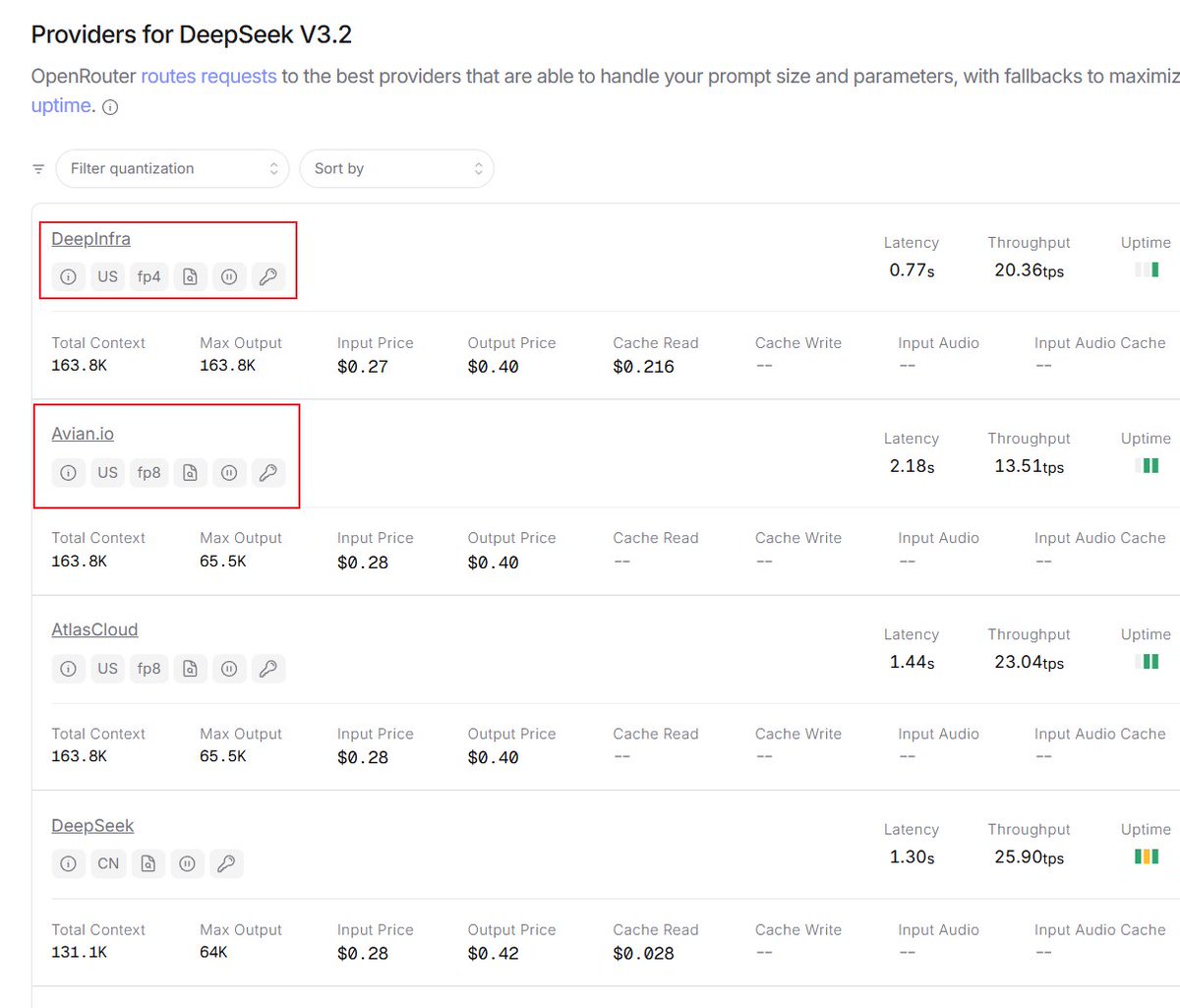

今天踩了一个大坑!我怎么不会想到,同一个模型,表现可以差距如此之大!

昨天deepseek 3.2 正式版上线后,能力比肩gpt5。于是我将日常任务的一部分交给了它。它一共负责了30多份分析报告,结果有8份出现严重的问题。

这个结果实在令人意外, 因为离预期相差实在太大。所以今天我接了官方的api接口,又重新跑了一遍。

结果,这次运行结果非常不错。确实有gpt5的水平,跟之前的完全不是一个水平的。

想来想去,问题就出在第一次的openrouter的api。大家知道现在的大模型特别多,如果每家都要注册,充值、还要配置调用代码,特别繁琐。而OperRouter集成了几乎所有的大模型,特别是测试新模型的时候,非常的方便。

而deepseek V3.2的模型供应商,是提供fp4 fp8。FP4 和 FP8 指的是浮点数(Floating Point)的数据精度格式。简单来说,它们是用来“压缩”模型的技术(即量化),目的是让模型跑得更快、占用的显存更少,同时尽量不损失智能程度。

虽然对大部分模型,fp4 fp8几乎不会损失智能程度。但是deepseek采用的DSA 架构,有可能因此受到比较大的影响。

嘛呀,AI的世界还是太复杂了。

从长期趋势来看,本轮4年的周期即将结束,将进入下一轮的周期。有很多观点认为:本轮已经不再有4年的周期。我觉得不完全赞同,也不完全反对。我个人感觉是:不再有之前那样的大熊市,或者说之前牛熊非常分明的现象。

1)btc并不会出现以前熊市的那么大调整,不会像22年那样从6.9万跌到1.5万。但是这中间可能会有较长时间,幅度不小的调整。

2)市场也会有明显的表现:包括

—市场的资金有比较大的集中的撤退,这是那些相信牛市顶部的人,以及已经赚够了足够资金的人的行为。

—行业出现比较大洗盘,特别是这个周期出现的大量的项目,大量会归零,只有少量的能存活下来。(并且这个过程早就已经出现)

—资金层面的大清洗,如1011的爆仓。并且我总觉得之后的还有黑天鹅没有爆出来。

所以,在未来的3年时间内,整个走势大概率是

1 BTC是慢牛

BTC整体是一个震荡上行的走势。

1)以美国机构为主的入场资金

2)特朗普的加密中心的战略推动

3)美联储处于降息周期。

但是就像前面所说的,中间可能会遇到较长时间,幅度不小的调整。

2 行业洗盘,大量山寨会归零

每一轮都会经历项目的大洗牌,本轮也是。但是不一样的,上一轮归零都是你一眼看得出就是垃圾的项目。但是,本轮会有大量看上去正儿八经的项目也会归零。本轮,大量高市值的项目上市。看上去,它是有团队、有产品、有运营,也有看起来不错的叙事。但是,他们的叙事只是包装起来的,他们的产品可能市场并不需要。他们的现在的市值,为了出货而硬拉起来的。而他们,初衷是为了在25年收购一波的。

另外一个不同是,上一轮的项目,是btc开始下跌的时候,他们才开始跌。 而本轮,在项目方完成了出货赚到了钱,他们就已经开始跌的。有的已经一年前就开始跌。同样,之后btc调整后开始涨的时候,他们也基本不会涨了。

3 整个行业会迷茫,会有1~2年的衰退

22~25年 已经是基建完善并开始大规模应用的周期。比如eth的layer2扩容早已完成,solana的高性能已经维持了几年,btc的layer2大量涌出,模块化、账户抽象早就完善。

于是回过头来,我们去总结的时候,会发现基建早就完善,但是大规模应用却没有发生。上一轮周期至少还留下了Defi,这一轮啥都不是。除了亏钱,啥都没有留下。而感觉很有希望了AI、RWA、稳定币等,也没看到任何的增长。

当看着曾经一个个美好的故事都在一点点归零,我们就会心里就会怀疑,未来在哪里。

但是,虽然行业会进入衰退期,但是也将有巨大的机会。本轮,太多的资金、人、项目,人潮涌动,嘴上说的是相信web3,实际上只是为了暴富而已。而当潮水褪去,那些真正的好项目就会浮现出来。

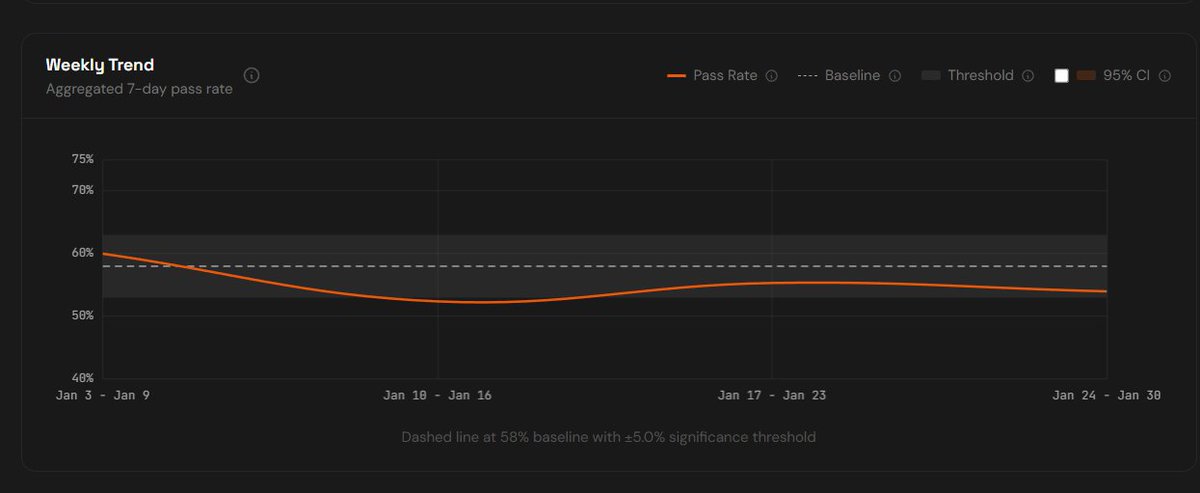

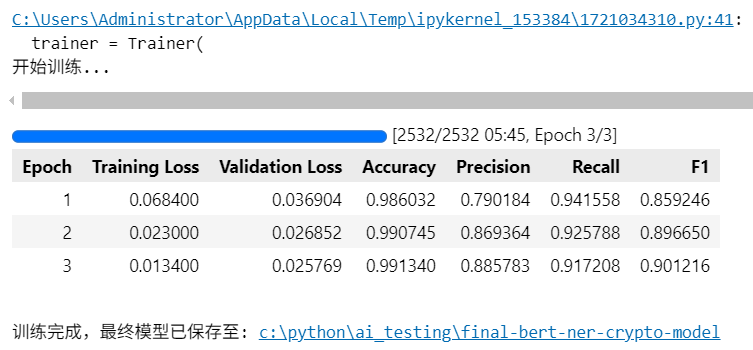

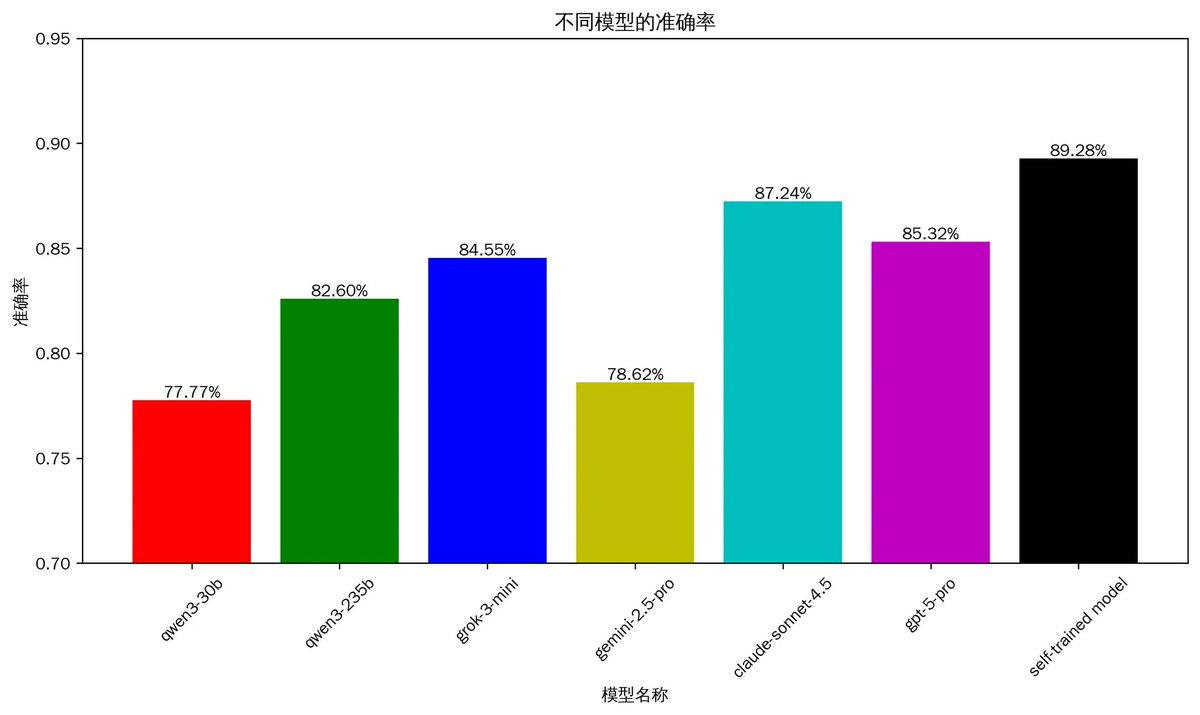

跟大家汇报一下,最近我微调了一个自己的模型。用于专门从推特文章中识别加密代币。结果还不错

-准确度已经超过了现在最强的大模型,

比如sonnet 4.5,gpt5

-分析速度是他们的250倍

-成本只有1/100

所以,我来介绍一下这个模型,并总结一些经验我踩过的坑。

1 模型介绍

推特是币圈人获得最新消息、寻找潜力项目的最重要的途径。要想做好推文分析,最最基础的第一步就是识别推文中的加密货币。

但是对推文分析又是比较复杂和困难的,因为

1)每个人的表达方式各式各样,不像新闻稿件、专业论文有比较固定的格式

2)推文中的文字、语法的错误率明显高于此类文章

3)大量新内容,并不在AI训练数据库内

在这方面,我做了大量的工作。我最一开始的方向是使用现有的大模型进行分析,并且测试了几乎所有的模型(包括不同的参数)。

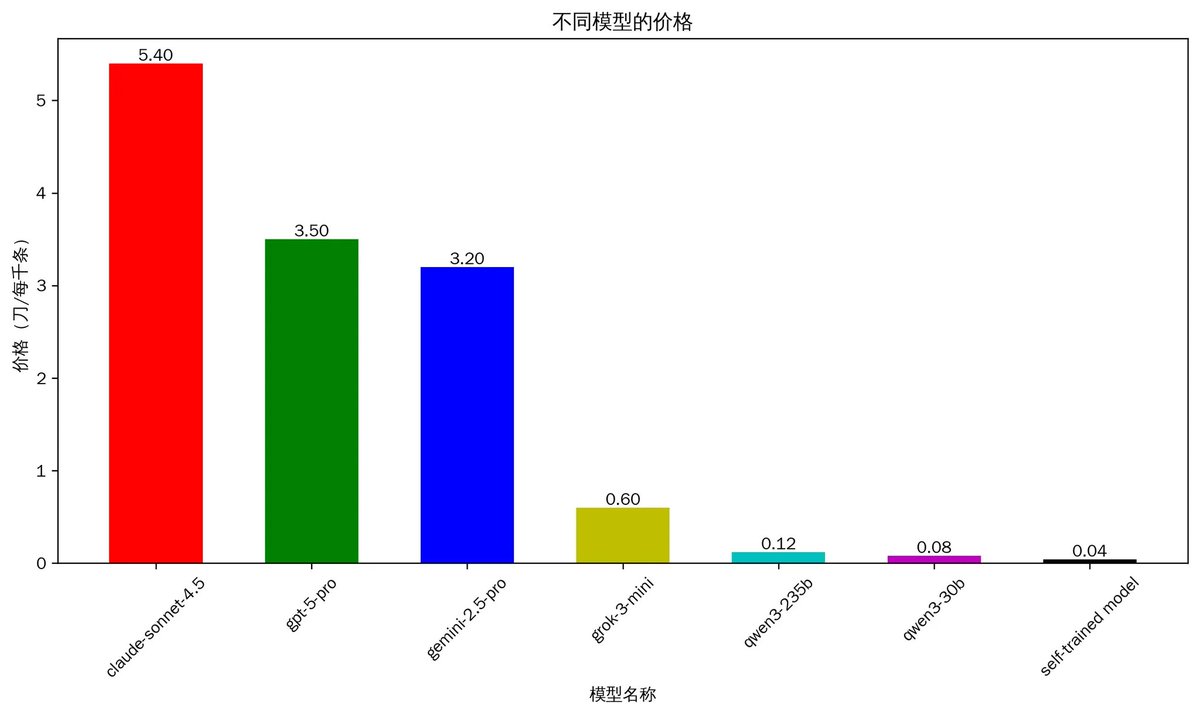

然后我发现现有的大模型的准确度能够基本满足我的需求,但是其高昂的价格,最终让我决定自己微调一个模型。下面是具体的数据

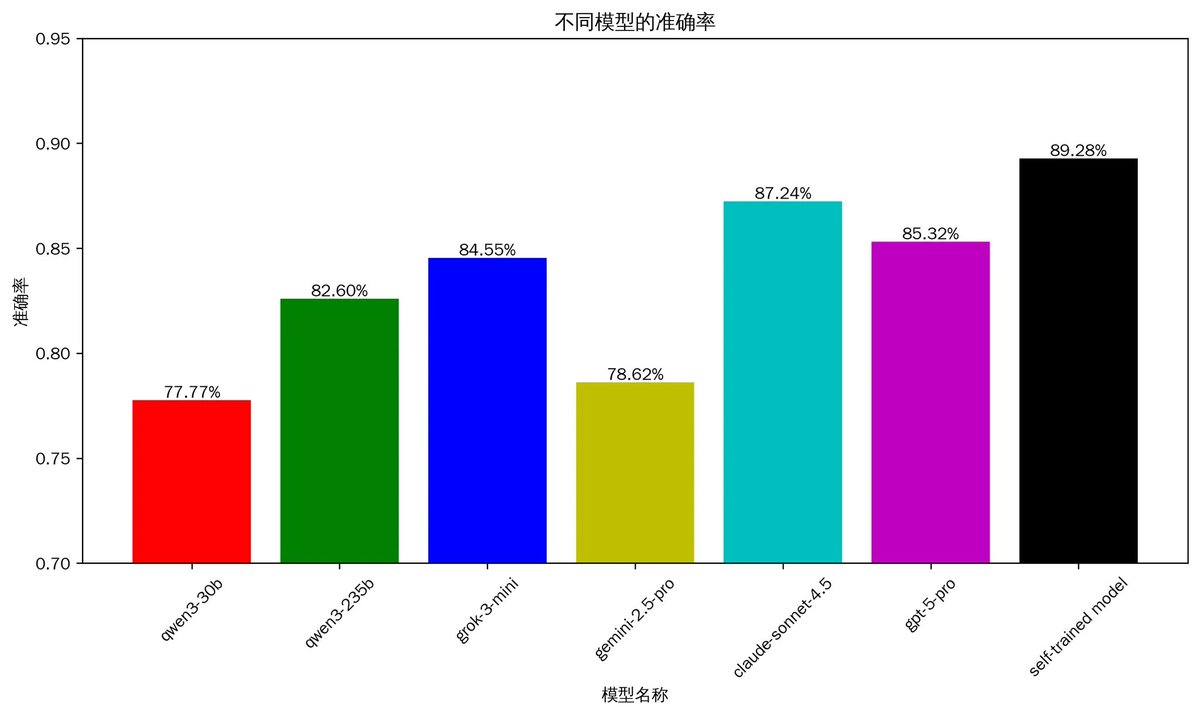

1.1 分析推文的准确率

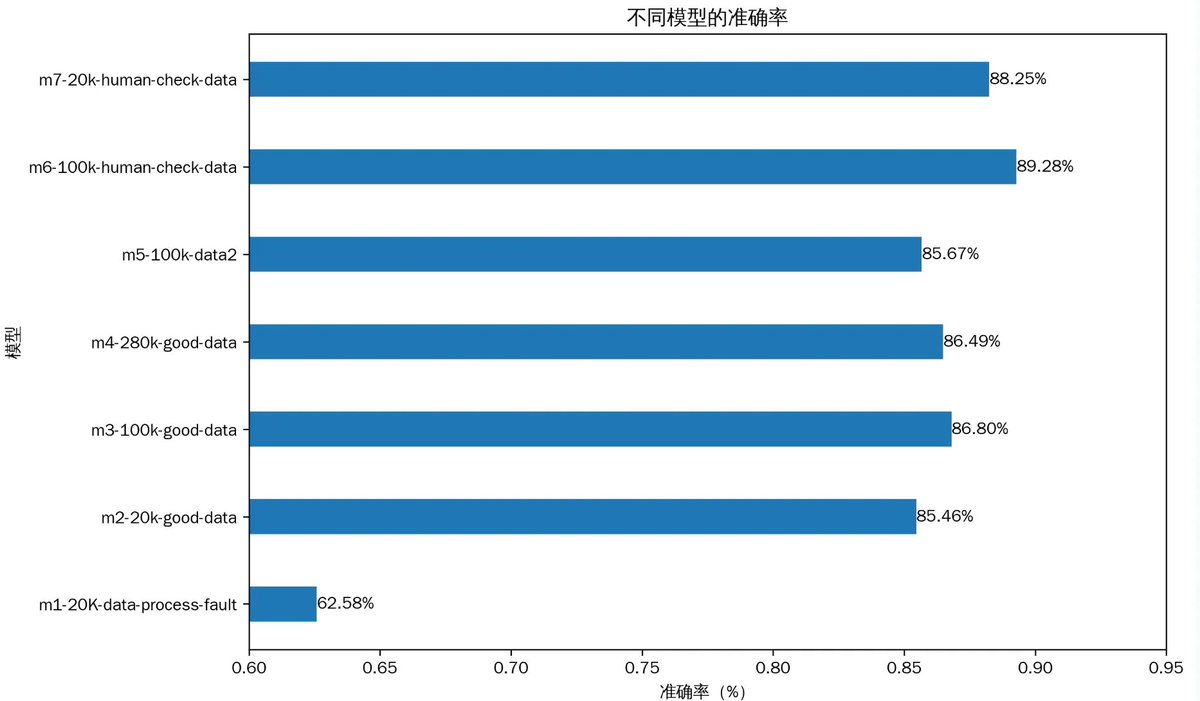

上图是准确率,可以看到自己训练的模型已经达到了89%,超过了claude-sonnet 4.5的87%,以及gpt-5 的85%。其中比较意外的是,同为第一梯队的gemini 2.5 pro在这方面的表现并不好,只有78%。而国内的开源qwen3 235b的表现要好于gemini 2.5 pro

说明一下,上面的准确率:是同一批1057条精细挑选的推文中执行,充分包含不同的场景推文、中文和英文、文章长中短、讨论代币数量0~6个不等。并且不在训练数据之内。

有人可能认为这个准确率并不算高。其实真实的准确率一定会高于现在的数据。是因为现在测试数据都是币圈的,而真实的推文有大量非币圈的内容。具体来说,现在的1000多条测试推文都一定是币圈的,准确度在90%左右。但是真实的情况是,可能是3000条中有1000条是讨论币,还有2000条讨论其他话题的。所以真实的准确度会达到96%以上。

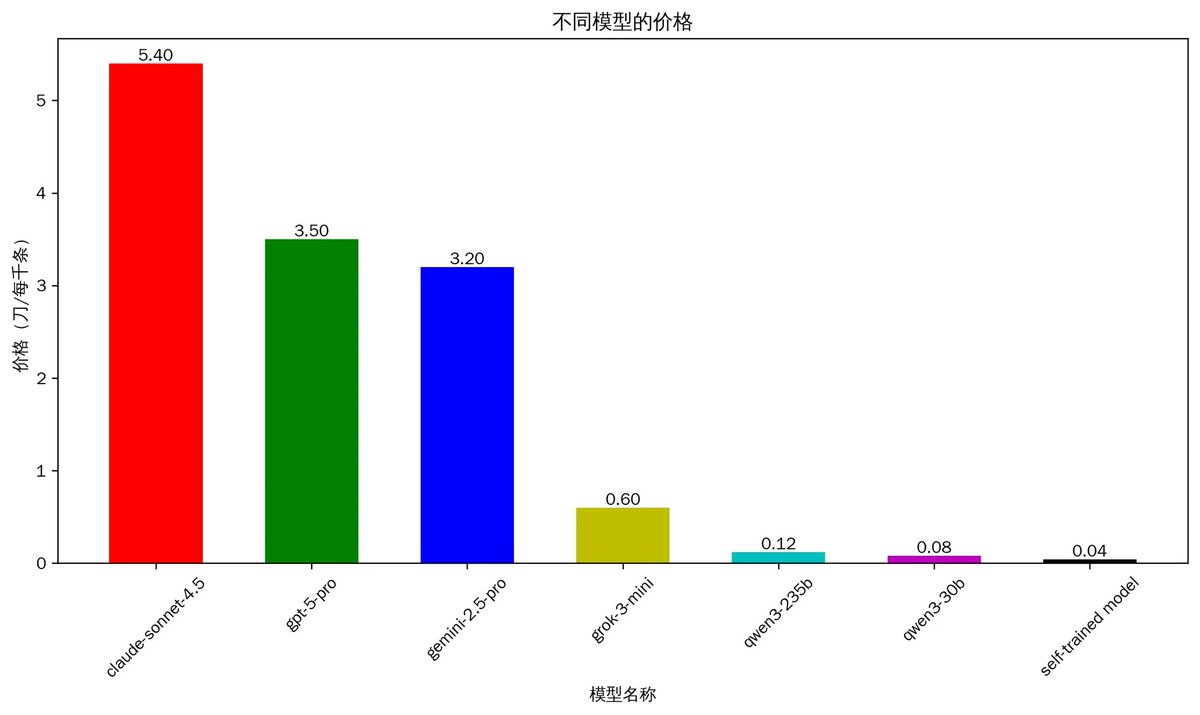

1.2 分析的成本

成本是考虑的另外一个因素。说实话,促使我微调一个自己的模型的原因,就是现在的大模型太贵了。

从上图中可以看到,成本最贵claude4.5, 分析一千条推文大概需要5.4刀,这个价格其实是很贵的。同处于第一梯队的gpt5 和gemini2.5 需要3刀多。而qwen3相对比较便宜,但是也需要0.12刀。我们可以算一个简单的账,如果一个账号关注了1000个人,那么根据经验,这些人一天推文数量大概在1500条。即使使用qwen 235b,一日也需要0.18刀左右。如果只是个人日常使用,完全可以接受。

但是如果需要做一个产品,有1万个用户。那么每月费用将要达到5.4万刀,这将是非常大的一笔开支。而现在自己训练的模型,跟sonnet 4.5相比,成本降低了100倍,但是准确率依然超过他们。

(说明:由于推文的字数差别非常大,所以单次AI分析的成本也是差别巨大,而上面的价格计算的是平均数)

2 一些经验总结和踩过的坑

接下来,聊聊这段时间做的一些心得和感受,当然主要是踩的的坑吧

经验1:比起大而全的大模型,使用小参数解决单一任务才是正确的选择

现在,整个社会的风向都是往更大参数、更强的性能。我一开始也是这样的想法。所以我一开始的方案就是调用现有大模型的api,我测试了多个AI模型,试图找到成本低又能满足需求的大模型。但是最后发现并不是最优解。

然后后来发现,一些参数很低的模型。虽然最初回答一个简单问题,看起来还有点弱智。但是,经过细心的微调,在分析推文的任务上,会好于现在最强的模型。优势是成本低,速度还快。

经验2:优质的数据至关重要。

微调的核心是优质的数据,这方面几乎占据我90%的时间。

在数据方面,我遇到的最大的一个坑是来自标准数据处理流程。简单来说,在进行微调前,需要对数据进行一系列转化。这些工作就是标准化的,Huggging face有标注代码库可以直接使用。于是,当我使用精心准备的数据,进行微调的第一次微调,出来的结果准确率只有62%。这样的结果让我一度质疑自己训练这条路是否走得通。几经排查才发现,使用标注库处理出来的数据有很多的问题。

另外一个大坑,就是代币名称是常见词的特殊处理。比如说near、in、ip等这些都是日常中常见的单词,需要进行区分处理。否则,微调后的模型并不只是对这些词错误那么简单。因为模的是对语言的学习。

说实话,数据处理中大大小小的坑还是很多,这还跟每个人不同的数据有关。

经验3:苦活累活是必不可少

现在的宣传导致大部分人都以为,在AI时代只需要花几分钟动动手,剩下AI都会做完。但是实际情况是完全相反的。依然有不少的苦活累活,比如尽管我的数据有AI的标注,以及使用代码处理,提高效率。但是数据的人工检查,依然花费了我7天的时间。

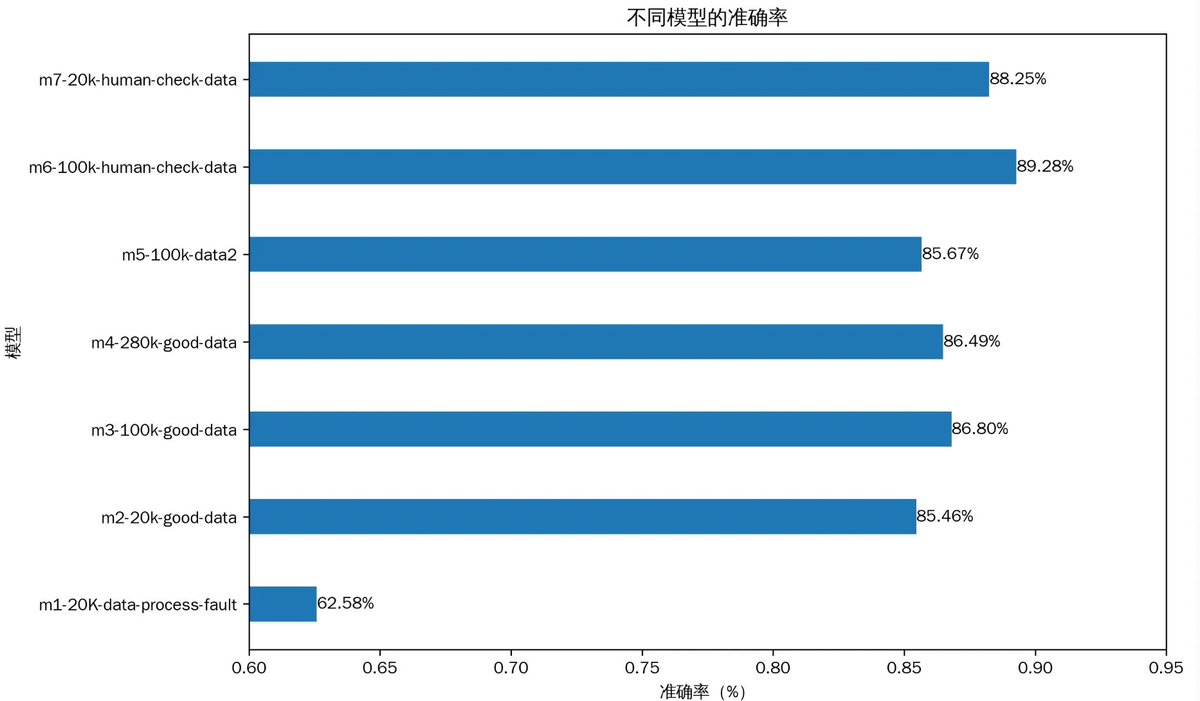

3 使用不同参数的微调模型

我前后一共微调了8个模型,为了测试不同的参数对最后结果的影响,我选取了其中的7个来分析。其中上图中,m1~m7

m1:在前文中介绍过,是我第一个微调的模型,但是由于使用标注的数据处理方式,导致数据处理错误。最终准确率只有62%左右。

m2:是在解决了M1的问题后,使用同样的数据量进行训练的。然后结果一下子就提升到了85%。这个结果是一下子提升到第一梯队大模型的水平。

m2、m3、m4 :分别使用20K、100K、280K的数据量进行训练,发现当从20K的数据,增加到100K的时候,准确率从85.6%提高到了86.8%。但是继续增加到280K的时候,准确率并没有提高反而下降到86.4%。这说明了数据量并不是越多越好,太多的数据会导致模型训练过拟合。

m6、m7:的数据是在前面的基础上面,做进一步数据校验。核心是人工审核,是的,10万条数据,我进行了人工审核,这就是最苦最累的活。从结果来看,数据质量的提高是m6、m7模型的准确率进一步提高的原因。他们的准确度也超过了世界最强的模型sonnet4.5。

4 总结

整体而言,这次工作虽然踩了很多坑,最后的结果还是让我非常的满意。这也为大批量实时分析数据打下了良好的基础。并且,根据这次工作掌握的经验,接下来可能对训练的数据做进一步的提高。

最近AI交易特别的火,身边不少朋友知道我一直弄AI,也来问我。

我给建议是不要弄,因为没有结果。

当我深入AI开发后,遇到的第一个头疼的事情,就是不确定性。

简单来说,当你问AI一个稍微复杂一点的问题(比如怎么样让人自己变成万人迷),其实问10次,10次的答案并不是一样的。

这样就是为何出现了复杂的prompt工程来约束AI的回答。但是即便如此,以我现在做的产品为例,依然需要用第二AI来检查答案,然后再用第三个AI来检查输出格式。

所以,可以看到,现在AI的应用在两个方面

1 是代码:因为代码有非常明确的语法规范,

2 是写作/视频等,因为它结果没有统一标准,很多个答案都可以达到优秀。

归根到底,AI是对人类进行大量学习后,成为全能的专家,但不是神。当你问是不是会涨的时候?因为没有标准答案的,结果就是10次回答可能会有不一样。而你只是随机拿到它其中的一个答案

而要解决这个问题,是需要给AI一个交易的标准,比如到120均线可以买等等。所以,最终还是你是交易者,AI是帮你干活的苦力。

沉痛悼念!杨振宁先生!

他是每个华人的骄傲,是华人科学家的顶峰人物。

人们可能只知道他的爱情趣事。却不知道,他的成就是可以与爱因斯坦,牛顿等相媲美的科学家。

也是20世纪后期开始,这位华人科学家是科学界最牛逼的存在。

主要工作:杨-米尔斯规范场论,是超越诺奖级别的成果。

在这个世界,存在这四种力量。而能够数学描述的是牛顿发现的万有引力,和麦克斯韦描述的电磁场力。而杨-米尔斯规范场论,它统一提供了数学工具,直接催生了粒子物理标准模型 —— 人类迄今最成功的基础物理理论。美国富兰克林学会评价其 “已跻身牛顿、麦克斯韦、爱因斯坦的工作之列

宇称不守恒:打破百年科学教条

它直接打破了物理学界普遍相信一个“常识”——宇称守恒。以至于提出第二年就被授予了诺贝尔物理学奖。获奖是杨振宁先生仅35岁,是历史上最年轻的诺奖得主之一。

除了上述两项“封神”之作,杨振宁在统计力学、凝聚态物理等领域也有大量开创性工作,例如:

杨-巴克斯特方程(Yang-Baxter Equation): 在统计力学和量子场论中极为重要的一个方程,它开创了“可积系统”这一庞大领域。

非对角长程序(ODLRO): 深刻影响了凝聚态物理中对超导和超流的理解。

你看到的是恐慌,而别人看到的是暴富的机会

有时候人和人之间财富的差异,就是来自认知的差异

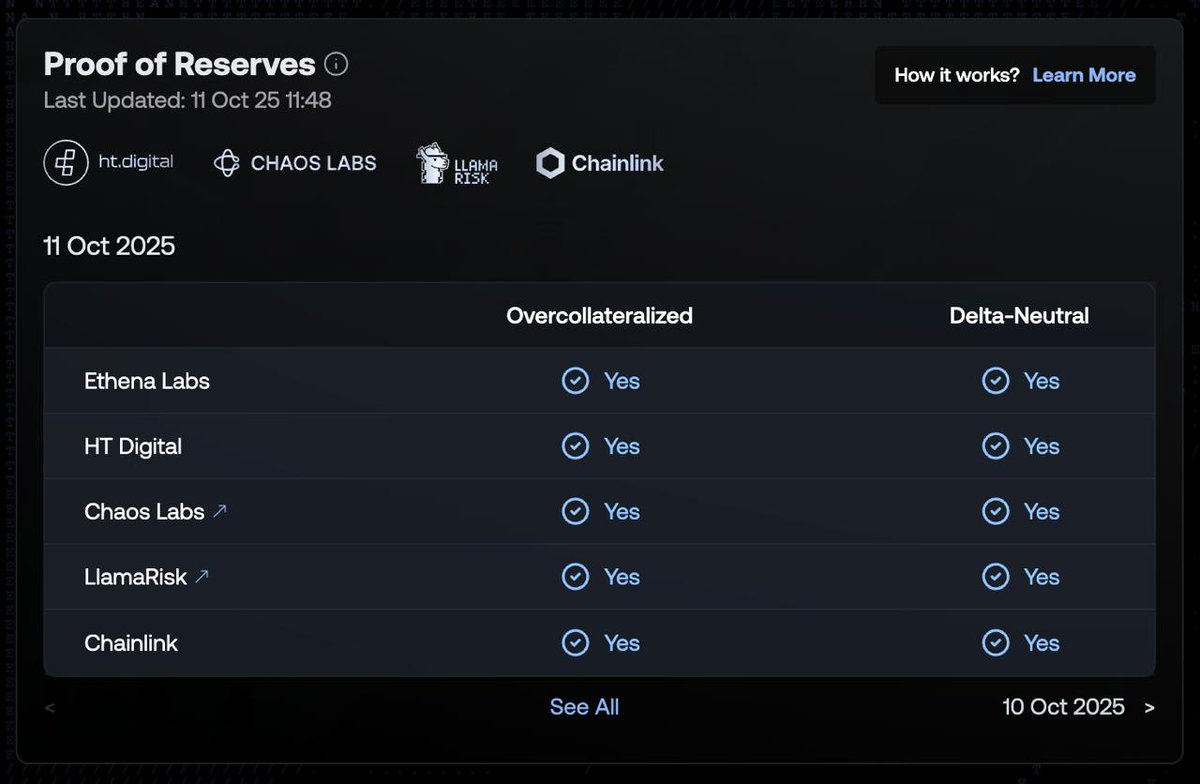

今天看到Ethena创始人的推文,其中写了USDe在1011发生的时候,经历了一次几小时内超过10亿美金的提款。有人觉得这是别人在恐慌抛售。不,你错了,这些人在赚的朋满钵满。

在1011期间,币安的USDe最低跌到了0.6。但是这并不是USDe脱锚(它锚定的是1usdt),而只是区域性的价格错位。因为市场恐慌,流动性不足的价格错位。比如在币安很多人使用USDe进行了循环贷,在市场下跌中被强制清仓,这才导致的USDe的价格下跌。所以这跟其他币的脱帽完全不一样。

而当时USDe真正的价值是多少呢?还是1美金。因为你在官方可以用一个1USDe兑换价值1美金的USDT(或者其他token)。当时官方的兑换一切正常。所以,当时你在币安买入,那就是妥妥的赚钱。而更加聪明的人,是在币安用0.6的价格,到官方兑换1美金的USDT,然后再去币安买折扣价的USDe,再去官方兑换。周而复始。

你别小看折扣不高。但是它速度非常快。并且最重要的,它是无风险!它是无风险!它是无风险的!因为 Ethena 的铸造与赎回功能完全正常。

有时候认真认真研究透一个项目真的很重要。特别是现在MeMe流行的时代,没有多少人愿意做这种头大的事情。但是有时候真的可以赚钱。不仅能赚钱,有时候也能保命。当年的luna就是不同的命运,由于不了解机制,UST出事的时候,身边好几个千万级别的朋友抄底,直接抄归零了。

以上

昨天USDe的脱锚引发了很多人的担心,而最担心的是USDe会不会成为第二个luna?

我就来科普一下。先说结论:不可能,因为机制不一样。

1 USDe和ENA的机制

USDe和UST虽然都是使用抵押物合成的资产,但不同的是,UST是使用它自己的项目代币Luna来进行抵押合成,在上升螺旋的时候,会带动Luna币价飞涨,因为用户要不断购买Luna来合成UST。但是到了熊市,UST脱帽的时候,就会让luna加速下跌。

USDe不同的是,它并不用ENA来抵押生成。而是BTC、ETH的大币种,稳定币来生成。

并且最重要的一点,USDe吸取了其它稳定币协议的失败教训。对BTC、ETH等非稳定币币种进行了delta对冲。当它收到100美金价值的ETH生成USDe后,会去交易所开空100美金价值的ETH进行对冲.

这样,USDe不会因为eth暴跌导致的抵押物价值不足,而是永远都保持价值1美金。

2 USDe的收入来源

USDe的年化收益很高,一般都在5%左右。它也不像Luna那种是代币奖励。而是实打实的收益。USDe的收入来源有三个。

1)做空对冲的收益,也就是吃的资金费率。根据历史来看,除了22年大熊市,其他时候的资金费率收益,基本都在10%左右。

2)质押收益,像eth、btc拥有质押的收益

3)稳定币的收益。例如跟usdc合作,对方会提供奖励。

USDe的核心是delta对冲,它既保证了它的价值不会收到抵押币价的波动影响,也为USDe提供了主要的收入。

当然delta对冲会有一些难度,所以可能一开始USDe增长比较慢。在经历3年多的稳定运行后,行业也接受了团队的水平,所以才引来了快速增长期。

这次提醒的应该算是非常及时。希望大家都躲过一劫吧。

那就具体聊聊如何判断的?简单来说,看三步

一看资金

资金是最底层的逻辑。无论市场如何变化,资金是实打实的买入和卖出的。而资金量决定了行情的高度。

具体来说,资金可以分为场内资金和场外资金。21年的时候,是场外资金不断入场,形成一个超级大牛市。而现在,没有场外资金(购买山寨币),所以不会有山寨币大牛市的。

再说场内资金,它也影响很大。24年10月发起的行情,这波也维持了很久,很多暴涨。这是因为在行情开始前,市场一直在下跌,场内大部分持usdt。

而今年不一样了,市场没怎么跌,很多人持有着币,场内自己有限,所以潜在的购买力也远不如去年。

二 看情绪

出现几个暴涨币后,会引发市场的情绪。市场的情绪让人控制不住的买买买。这就是大部分人容易在顶部接盘的原因,因为这并不是理性决定。而是受到市场情绪影响。

市场情绪持续几天后,大家都已经买买买了,购买力会枯竭。特别是潜在购买力量不大的时候,很容易发生。

三 看标志性现象

前面两看后,已经大致了解了一波行情的高度,以及市场的情况,那么标志性现象就是具体的决策时间点。

这次的标志性现象就是币安人生 和 客服小何。 币安人生是在全仓fomo的情况下,一波拉到4亿美金。而后来的客服小何,最高只拉到1亿。尽管后来一姐喊了几次,但是依然上不去。这已经是非常明显的信号,市场资金已经没了。

所以,这次调整基本已成定局。只是又碰到特大嘴的关税,形成了大跌的共振。

这是让web3大规模应用的很好的范式

1 与现有的web2 无缝的连接。不需要用户有额外的学习时间和成本。直接在银行软件使用,法币与USDe的转化零手续费。

2 涉及大量Web2用户,涉及45个国家的日常金融。

3 有对新用户足够吸引力的点,年化收益到达5%,足够超过大部分的无风险理财。

以上满足三个,我就觉得这个事情靠谱。

币安内持有USDe,年华为12%。这应该是现在无风险收益最高的理财了。

而且什么都不需要做,只需要在币安账号里面有USDe就可以。不需要锁仓,甚至不需要放入理财里面。

而且USDe的收益是有实际来源的,因为它是抵押生成的稳定币,它的抵押品例如ETH会有质押收益。并且协议会开空头衍生品头寸来对冲,赚取正融资率和基差收益。

如果你要参与,也非常的简单,币安有USDe和USDT的交易对,买一下就行了。

现阶段,应该是为了增加USDe的使用用例,项目方做的推广活动。从链上的情况来看,USDe在ETH链上,币安钱包有7.3亿, BSC链上有8千万枚。所以币安交易所现在一下子有8亿枚了。

数据不错,希望再接再厉。

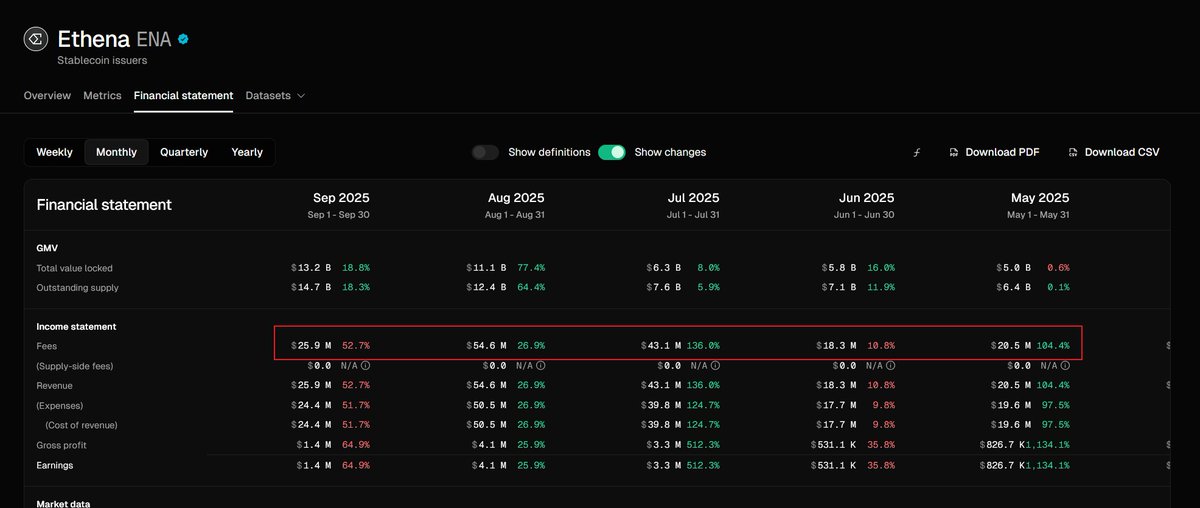

很多人没注意到,Ethena费用开关转换条件已得到满足。这其实是Ethena 是在偷偷的告诉大家,我现在超赚钱的。

因为赚很多钱,所以会将部分协议收入分配给出来。根据tokenterminal数据显示,Ethena 八月的收入为54.6M,而5月份才20M。 表面看,收入增加了2倍多。而这增加的主要原因的是USDe的增长。

我之前说过USDe进入了快速增长周期。这是在积累一定时间后,生态开始快速增长。之后出现币安支持USDe理财的好消息。而随着USDE继续快速增长,那么Ethena的月收入也不止54.6M。

稳定币赛道果然稳稳的赚钱,难怪大家都要挤破头的加入。

今天看了CZ在香港大会的视频演讲,突然明白了币安Alpha的战略意义。

最近几个月,链上变得特别的冷淡,整个市场唯一有热度就是币安Alpha了。在之前,我只是简单的把Alpha作为币安的一种新上币方法。现在突然意识到,它对于币安具有重大的战略意义。

总所周知,币安Alpha以及Wallet拥有两大特点

第一:中心化交易所的用户体验

第二:链上交易

对于链上交易。在之前,我看好它的逻辑是:大量项目方在中心化交易所收割韭菜的行为,导致大量的资金把重心转移到链上,创造大量了的财富机会,而这个财富效应又会进一步吸引资金。但是,这种逻辑会遇到瓶颈,在到达一定泡沫之后资金就会撤离。也就是现在链上面临的状态,行业也出现了迷茫期。

而CZ的演讲让我意识到了另外一个逻辑,那就是在未来10~20年,会有大量的链下的资产上链。这些资产的上链就会有大量的链上交易的需求。同时未来AI Agent的交易也一定是在web3链上,而不是现有的金融交易体系。因为它需要满足,没有kyc认证、快速、低成本等要求。

我个人认为,像GMGN和OKX看到的是第一层的逻辑,就是web3行业内对链上交易的需求的增长,所以他们的产品形态都是围绕着这个底层的设计的,重点自然会放在web3钱包,链上的交易地址的行为等等。

币安的明显是第二层的逻辑。所以,币安Alpha以及Wallet就拥有了开始的第一个特点,中心化交易所的用户体验。因为如果说链上的核心逻辑是未来大量的链下资产的上链,所以就会伴随这是有大量的web2的用户需要链上交易。

现在的web3对新用户来说还很友好,链上的一整套东西非常的复杂。虽然业内在一直努力,现在也支持社交账号手机号注册、实现抽象钱包多链交易等。但是这只是第一步,之后新用户依然要掌握密钥保管、链上的资产等一套新的资产逻辑。就拿我自己亲身经验来说,每次向朋友介绍入门的时候,都要费口舌的说2个小时。

所以,中心化的用户体验对新用户至关重要,也以为着可以承接未来从RWA和AI带来的链上交易需求的大量用户。从这个角度看,CZ的战略眼光确实非常牛。

vibe coding 的日子1

1 理想中:

ai 1:写完我完整的需求

ai 2:根据需求检查代码,找到几个小问题,然后修复

ai 3:再次检查,代码完美。

然后,愉快的手工。

2 实际情况:

ai 1:写完我的完整的需求

ai 2:检查代码,发现3个重大问题,修复

ai 3:检查代码,发现4个重大问题,修复

ai 4:检查代码,发现2个重大问题,修复

ai 5:检查代码,没发现重大问题

好吧,保险起见,换个大模型最后再检查一次吧。

ai 6:检查代码,发现8个重大问题,修复

ai 7:检查代码,发现2个重大问题,修复

ai 8:检查代码,发现3个重大问题,修复

ai 9:检查代码,发现10个重大问题,修复

每次发现检查出重大问题,我就特别想问它,nim刚才说修复完成的不就是你吗?

就想你当初生二胎的时候,想着的是一副兄友弟恭的美好景象,实际上却是两人天天干架。

ENA之前刚买一点头仓,本来想等个调整,给个买的好价格。结果这个消息一出,就直接大阳线上去了。

现在,稳定币已经是大资金明牌了,希望大家不要后知后觉了。

这次StablecoinX Inc 宣布作为其 $ENA 积累战略的一部分,通过 PIPE 融资筹集 5.3 亿美元买买买。这次融资中包括了yzilab,也就是之前币安lab。

购买BTC 和ETC的公司,是看中他们作为金融资产的增值潜力。而ENA这种还会另外一层含义

如果StablecoinX Inc 一直购买,它将成为ENA背后的实际控制者,因为现在很多上市公司在战略购买数字货币,那么反过来走,StablecoinX Inc因为而上市,也是顺理成章的事情。

AI正在一场智能革命,这也伴随着一场巨大的财富机会。

那么普通人如何抓住呢?这也是我一直在思考的问题。

最近一直有一种感觉,AI的技术更新实在太快,很快会出先的概念,比如GPTS、AI Agents、MCP、vide coding。而自己只是一个跟随者,一有新东西就去学习,看看有没有什么机会?但是实际下来,一是感觉一直这样会很累,二是其实是迷茫,因为不知道哪个会未来?

因为很多一年前的概念,当时号称炸裂、逆天,现在已经完全out了。

所以,应该跳出这个跟随的节奏,静下心来思考,未来AI的革命,底层的逻辑是什么?

我的答案(可能还不成熟),就是将稀缺能力规模化。

之前的工业革命,分别进行了将生产能力规模化、将物质传输规模化,以及将信息传递规模化。

而稀缺能力,成为很多人想要的内容。比如一名老医生、专业律师、高级工程师。这些在现在的社会都是稀缺资源。

这些其实也都是有钱人的特权,富人就能拥有专家级的医生给出健康建议,可以请到好律师为保障自己的法律权利等等。

而AI时代,会可能全部都变了。打造特定领域的专业的AI, 可以让大部分人获得专家的服务。

就比如现在的vide coding,本质上就是让普通人都拥有了一个专业的编程团队,完成了自己的想法。而未来可能有更多这方面的应用会冒出来。

Ethena的稳定币USDe要进入快速的增长周期了。

根据官方公示的数据,USDe的供应量从7月14日的53亿,到今天为123亿,在短短45天的时间增长了70亿。在之前,USDe的供应量开始到53亿,却用了将近一年半的时间。

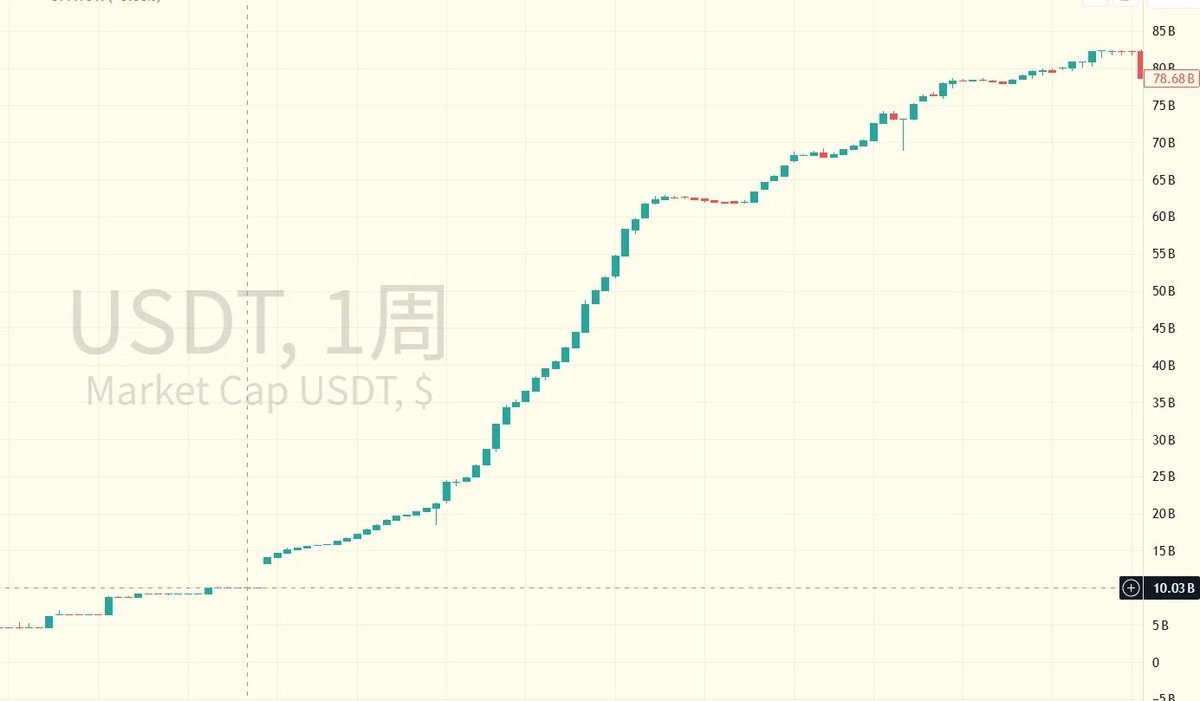

我去特地研究了USDC和USDT的历史数据,他们的增长的规律也发现了惊人的相似。下面两个图分别MarketCap的变化趋势,从图中可以看到USDC在一开始也是缓慢的增长,并且在30亿的位置一度持续了很久。但是在20年12月开始,FDV开始了快速增长,一路上涨到了556亿美金,增长了1800%以上。

同样USDT的增长也类似,大概在60~80亿的位置,市值开始迎来爆发式的增长,一路干到786亿美金。现在已经到达了1673亿美金。

我想这规律背后的逻辑大概是这样的:在一开始的时候,市场认可这个稳定币需要一定的时间,还包括相关的生态项目。就像一个新品牌,需要时间来做用户的心智培养。而当到了一定阶段了,从数据看差不多50亿美金,市场的认可度提高,信任度也有了,变开启增长的飞轮。

@ethena_labs