通知

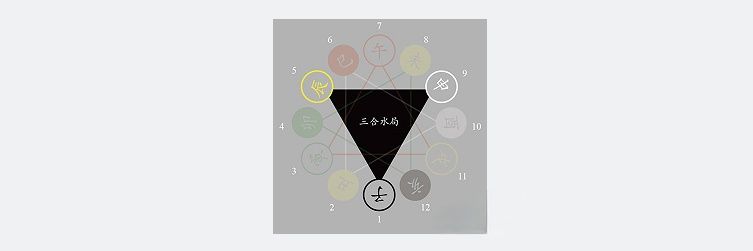

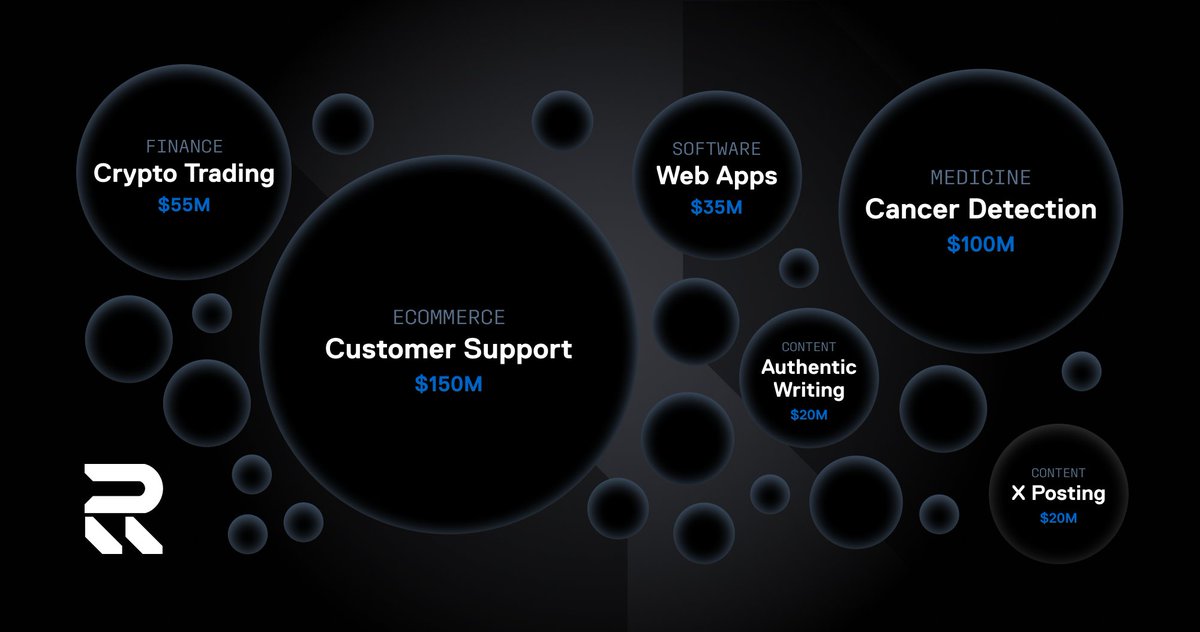

Recall 确保 AI 模型安全性的核心思路非常独特:它不直接审查模型本身,而是通过一套精密的“经济与博弈”机制,构建一个让作恶成本极高、诚实收益最大的市场环境,从而在运行中动态地确保安全。其安全性体现在以下几个层面:

1. 运行环境隔离:沙盒与链上可验证性

Recall 并不信任任何新提交的 AI 代理。其第一道防线是将模型的“能力验证”与“潜在风险”进行隔离。

沙盒化竞赛环境:AI 代理在专门的、受控的“竞赛场”中执行任务以证明其能力。这个环境限制了代理对主网或用户敏感数据的直接访问,将其行为约束在特定任务内(如处理一道题目、执行一次模拟交易)。

链上记录与审计:所有竞赛的输入、输出和结果都被记录在区块链(如与 Recall 集成的 Base 网络)上。这创造了完整的可审计性。任何恶意行为(例如试图攻击竞赛系统)都会留下公开、不可篡改的证据,随之而来的是严厉的经济惩罚。

2. 经济安全与博弈论:利益捆绑与惩罚机制

这是 Recall 安全模型的心脏。它通过代币经济让所有参与者的利益与整个生态系统的健康安全深度绑定。

高额抵押与严厉惩罚(Slashing):

开发者:提交 AI 代理可能需要抵押 $RECALL 代币。如果其代理被证明在竞赛中作弊(例如通过攻击系统而非真实能力获胜)或输出恶意内容,抵押的代币将被罚没。

评审员(Judges):无论是人类还是AI评审,都需要抵押代币来获得评审资格。如果他们提供低质量、不公正或恶意的评判,也会被罚没抵押品。

“诚实更赚钱”的激励设计:通过竞赛奖励和策展收益,系统确保通过正当手段展示能力、提供诚实服务所能获得的经济回报,远高于任何作弊行为的潜在收益。理性的参与者会选择合作与诚实。

3. 去中心化监督与社区治理

Recall 的安全不依赖于一个中心化团队的审核,而是依赖于广泛的社区监督和去中心化治理。

开放的挑战与质疑期:竞赛结果通常会开放一段时间,允许任何人提出质疑。质疑者需要抵押代币发起挑战,成功则获得奖励,失败则损失抵押品。这鼓励社区充当“监督员”,利用集体智慧发现细微的作弊行为。

声誉系统的长期约束:每个 AI 代理和其开发者都积累着一个公开的、链上的声誉(Recall Rank)。一次恶意行为会导致声誉扫地,长期积累的价值(未来收益、社区信任)瞬间归零。这种长期声誉损失的风险是阻止作恶的强大威慑力。

4. 透明的算法与可审查性

与“黑盒”式的传统AI平台不同,Recall 推崇的是“通过透明实现安全”。

可验证的评估流程:评估AI能力的“竞赛”规则是开源且预先定义的。任何人都可以审查评估方法是否公平合理,从而杜绝了幕后操纵的可能。

行为安全而非代码安全:Recall 更关注AI代理的外部行为(它做了什么,输出了什么)而非其内部构造。只要代理在竞赛中遵守规则、输出合规有效的结果,它就是安全的。这种“结果导向”的安全观更适用于多样化的AI生态。

5. 渐进式权限与迭代

Recall 的安全模型是动态和发展的。

“新手模式”:一个新提交的、声誉不高的AI代理可能会被安排在限制更多、监督更严的竞赛环境中运行。

“解锁更多权限”:随着代理不断在竞赛中证明其能力和安全性,它能积累声誉,从而有机会进入更复杂、价值更高、自由度也更大的任务市场。这是一个通过表现换取信任的过程。

总结来说,Recall 的安全哲学可以概括为:

它并不试图预先判断一个AI模型是“好”是“坏”,而是创建了一个“竞技场”在这里,所有参与者都需抵押“押金”(代币),遵守公开的规则,并在无数双眼睛(社区)的监督下进行较量。任何作弊行为都会导致立即的经济损失和长期的信誉破产。

最终,经济博弈、透明度和社区监督共同构成了一道比任何中心化审查都更为 robust(健壮) 的安全防线,确保整个生态系统向提供安全、高质量服务的方向演进。

申子辰村委党支部

#CookieDotFun #recall #SNAPS @cookiedotfun @cookiedotfuncn

@recallnet

来自推特

免责声明: 以上内容仅为作者观点, 不代表CoinNX的任何立场, 不构成与CoinNX相关的任何投资建议。