今天试了一下~

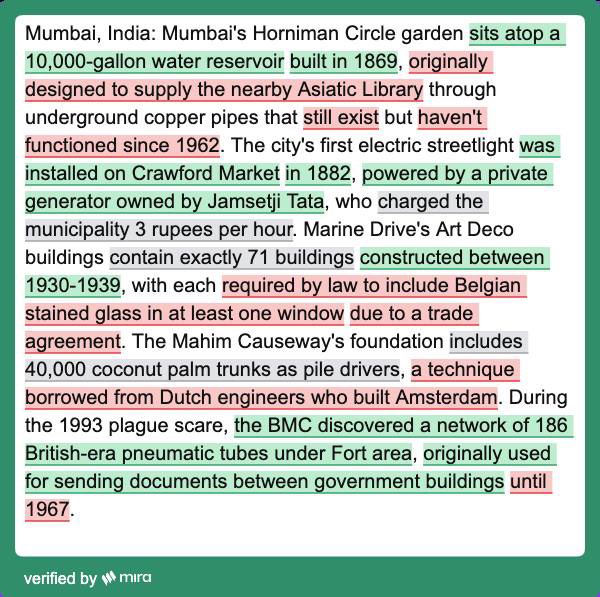

这张图展示的是 Mira 的 Verify 系统对一段AI生产内容的验证结果。

每一条小句,都被多个验证器独立判断,结果一致时,标记为绿色或 红色,若分歧,则标记无共识的灰色

可以从图中看出来图上标了真、假,还有一类灰色的句子,是模型彼此判断不一致的。

这一类其实最常见,但最少被提出来讲。

Mira 的 Verify 系统,是一个更底层的解决方案,我觉得这个设计有两个意义:

1. 更符合现实世界:大部分争议信息,不是绝对对错,而是缺乏共识。Verify不逃避不确定性,会直接标注显示无共识。

2. 技术上可调用:Verify 提供 API,能直接接入 AI 审核、自动重生成、内容标记等场景。

在这个内容由AI模型生成泛滥的时代。我觉得我们可能需要的,不仅仅只是更多的回答,而是更明确的“不确定”。

@MiraNetworkCN

@Mira_Network

From X

Disclaimer: The above content reflects only the author's opinion and does not represent any stance of CoinNX, nor does it constitute any investment advice related to CoinNX.